В 2009 году, на ежегодной научной конференции SIGMETRICS, несколько исследователей, трудившихся в Университете Торонто с данными, собранными и предоставленными для изучения компанией Гугл, опубликовала очень интересный документ DRAM Errors in the Wild: A Large-Scale Field Study посвященный статистике отказов в серверной оперативной памяти (DRAM). Не смотря на то, что подобные изучения и проводились ранее (к примеру изучение 2007 года, замечавшее парк в 300 компьютеров), это было первое изучение, охватившее таковой большой парк серверов, исчисляемый тысячами единиц, в течении более чем двух лет, и давшее столь безграничные статистические сведения.

Смотрите кроме этого: Статистика продаж цифровой техники в Российской Федерации

Несколько дней назад я побывал на пресс-конференции одного из больших ритейлеров, где кроме результатов самой компании, приводились цифры рынка мобильных устройств, каковые мне показались увлекательными.В 2011 году из общего объёма реализованных в Российской Федерации телефонов лишь 20% были смартфонами, в 2012 году — 30%. Наряду с этим выручка от смартфонов была 67%.Весьма интересно взглянуть на долю реализованных смартфонов.

В случае если в 2011 году часть смартфонов на Симбиан была 48%, а на Android 31%, в 2012 году эти цифры превратились в 17% и 57% соответственно. Примерно такое же соотношение и в выручке.

Отмечу кроме этого, что та же несколько исследователей, во главе с аспирантом, а сейчас доктором наук Университета Торонто, Бианкой Шрёдер (Bianca Shroeder) ранее, в 2007 году публиковала не меньше занимательное изучение, посвященное статистике отказов твёрдых дисков в датацентрах Гугл (краткую популярную выжимку из работы Failure Trends in a Large Disk Drive Population (pdf 242 KB), в случае если вам скучно просматривать целый отчет, возможно отыскать тут: http://blog.aboutnetapp.ru/archives/tag/гугл). Помимо этого, их перу в собственности еще пара работ, в частности об охлаждении и влиянии температуры, и о статистике отказов в оперативной памяти, вызываемой, предположительно, космическими лучами высоких энергий.

Ссылки на публикации возможно обнаружить домашней странице Шрёдер, на сервере университета.Коротко о том, как как раз происходила сборка статистических данных. Дело в том, что в течении достаточно продолжительного времени (в напечатанной работе проанализирован период около 2,5 лет), в датацентрах Гугл планируют разнообразные эти иных событий и мониторинга в жизни оборудования в громадной базе, эти которой в будущем возможно разбирать за любой желаемый временной отрезок.(на фото, кстати, настоящий вид серверной платформы Гугл, как раз из таких «кирпичиков» планируют гугловские кластеры, размером в многие тысячи узлов, но, про них тут уже писалось)Результаты для того чтобы анализа и представлены в напечатанной работе.

И результаты во многом необычные, заставляющие по-иному наблюдать на привычные допущения и вопросы надёжности в области надежности серверного оборудования.Изучение со всей убедительностью показало, что влияние отказов в оперативной памяти значительно недооценивается, что отказы оперативной памяти случаются куда чаще, чем до этого это было принято вычислять, наконец, многие допущения, к примеру что оперативная память фактически не «стареет», как «стареют», увеличивая возможность отказов, компоненты с движущимися частями, такие как, к примеру, твёрдые диски, либо что перегрев губительно отражается на работе ОЗУ, являются неверными, и требуют пересмотра.без сомнений тот факт, что в последние пара лет, в связи со сравнительным удешевлением DRAM, и широким распространением совокупностей серверной виртуализации, очень охочих до количеств памяти, концентрация в одной серверной совокупности все громадных и громадных количеств ОЗУ, повышает и требования к ее надежности.Изучение продемонстрировало, что приблизительно каждый третий сервер (либо 8% модулей памяти) в замечаемых датацентрах в течении 2,5 лет изучения виделся со сбоем в оперативной памяти. Число сбоев, зарегистрированных совокупностью мониторинга составило более чем 4000 в год!

Большинство из них само собой разумеется была устранена применением ECC (Error Correction Code), применяемого в оперативной памяти, и более сложными его вариантами, такими как Chipkill (разрешает устранить многобитовые неточности, к примеру сходу в группе ячеек). Однако, Uncorrectable Errors, другими словами неточности, каковые не удалось исправить, и каковые, наверняка стали причиной фатальным не типа BSOD либо kernel panic видятся куда чаще, чем это принято вычислять.

А при применения памяти без ECC любая из таких неточностей — это наверняка BSOD либо kernel panic, либо важный сбой в работе приложения. Так как, к примеру, весьма многие хранят эти баз в памяти для ускорения ее работы.В сравнении с ранее опубликованным изучением, работа группы Шрёдер быстро повысила «ожидания» сбоев.

Так, они оценили события отказов в 25-70 тысяч сбоев на миллиард часов работы сервера, что практически в пятнадцать раз превышает более раннюю оценку, сделанную на меньшей популяции.С отказами в следствии неисправимых (uncorrectable, неисправленных ECC либо Chipkill) встретились 1,3% серверов в год, либо около 0,22% DIMM.Совокупности, применяющие «многобитные» механизмы, такие как Chipkill, имели число отказов в 4-10 раз меньше, если сравнивать с простым ECC.Другие увлекательные выводы, сделанные в напечатанной работе это:Рабочая температура, и ее увеличение мало коррелирует с возможностью сбоя в DRAM. Это еще один факт, что показывает, что бытующее до сих пор в индустрии вывод о губительности повышенной температуры на компьютерное оборудование и полупроводники (вывод, основанное на изучении 80-х годов) на сегодня направляться радикально пересмотреть.

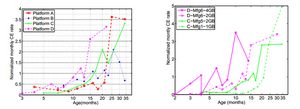

Это еще одно подтверждение этому факту, что уже был установлен, к примеру в работе о твёрдых дисках. Парадоксальным образом в том месте было обнаружено, что мельчайшее количество отказов HDD наблюдалось при температурах недалеко от 40-45 градусов, а ее понижение количество отказов увеличивало (!).При DRAM кореляция между температурой (в наблюдавшемся диапазоне около 20 градусов между самой низкой и самой высокой) и отказами была очень незначительной.(тут и потом на слайдах: CE — correctable errors, неточности, зарегистрированные, но исправленные ECC, UE — uncorrectable errors)Но значительно коррелировали отказы с интенсивностью обмена и загрузкой памяти с ней (частично высокая загрузка памяти воздействует и на ее температуру, само собой разумеется, но не всегда).

В полной мере возможно, что интенсивный обмен и громадный относительный количество заполненных данными памяти существенно увеличивает возможность стремительного обнаружения сбоя.Было обнаружено, что возможность взять повторный сбой в уже ранее сбоившем модуле памяти в много раз выше, если сравнивать с не сбоившем ранее. Это возможно позвано как наличием не хорошо выявляемого технологического брака, так и тем, что отказ, к примеру пробой заряженной частицей космических лучей, не проходит для памяти бесследно, даже в том случае, если неточность была скорректирована ECC.70-80% случаях, в то время, когда регистрировалась неисправимая неточность в модуле памяти, это модуль уже имел исправимый ECC либо Chipkill отказ в этом либо прошлом месяце.Было обнаружено, что относительно новые модули, выполненные с более высокой плотностью и более узкими техпроцессами, не показывают более большого уровня отказов.

По-видимому до тех пор пока в технологии DRAM технологический предел, недалеко от которого начинаются неприятности с надежностью, пока не достигнут. В замечаемом парке модулей было приблизительно шесть поколений памяти и разных типов (DDR1, DDR2 и FBDIMM различных типов), и корреляции между числом отказов и высокой плотностью и сбоев распознано не было.Наконец, с пугающей ясностью был показан эффект «старения» в модулях DRAM.

Более того, в памяти он проявился куда более очевидно, чем, напрмер, в HDD, где порог, по окончании которого отказы растут в разы, составил приблизительно 3-4 года.Парадоксальным образом статистика демонстрирует возрастающие скорость увеличения correctable errors с повышением возраста модулей, но понижающийся темп для Uncorrectable errors, но вероятнее это легко итог плановой замены памяти в серверах, каковые были увидены за сбоями.Необычным образом, DRAM, лишенная каких-либо движущихся частей, показывает значительный и длящийся рост correctable отказов уже по окончании года-полутора эксплуатации.Подводя итоги, хотелось бы подчернуть, что приведенные статистику заставляют пересмотреть привычные для многих, основанные на «житейском опыте» правила построения серверных эксплуатации и платформ датацентров, и позиция «чем холоднее — тем лучше», «память не изнашивается», «в случае если север верно собран, то он не ломается» и «ECC DRAM — ненужная трата денег, поскольку у меня десктоп трудится без ECC, и ничего». И чем скорее будут изжиты подобные шапкозакидательские настроения в столь важной области, как построение датацентров, тем, в итоге, будет лучше.А занимающимся темой желаю порекомендовать неизбывный источник сладости, пищи и интеллектуального упражнения для мозгов, как публикации ежегодных конференций группы USENIX, это вам, господа, не маркетинговый булшит, столь привычный нам уже всем, а настоящая важная наука, от которой не отмахнешься.

Случайная статья:

- Что нам стоит пульс измерить? варианты оптических пульсометров

- Обзор видеокамеры «видеомастер pro» или как заглянуть в темное труднодоступное место

9 мифов и заблуждений об Оперативной Памяти, о которых пора забыть!

Похожие статьи:

-

Как выбрать оперативную память?

Один из самых несложных и популярных способов апгрейда настольного компьютера либо ноутбука с целью увеличения его быстродействия содержится в повышении…

-

Статистика backblaze: определяем лучший hdd

Прошел еще год с момента публикации статистики применения HDD, с учетом количества сбоев в отдельных моделях твёрдых дисков. И по сей день показалась…

-

Обзор комплекта оперативной памяти hyperx fury ddr4-2400 16 gb (2*8 gb)

Здравствуй, Гиктаймс! Многократно было предсказано, что положение памяти стандарта DDR4 будет главным к 2016 году. На конец 2015 года предпосылок к…

Март 18, 2013

Март 18, 2013  intellcity

intellcity  Опубликовано в

Опубликовано в  Метки:

Метки: